揭秘AI金融决策背后的法律透明度之谜:问责困境如何破解?

2024-03-21

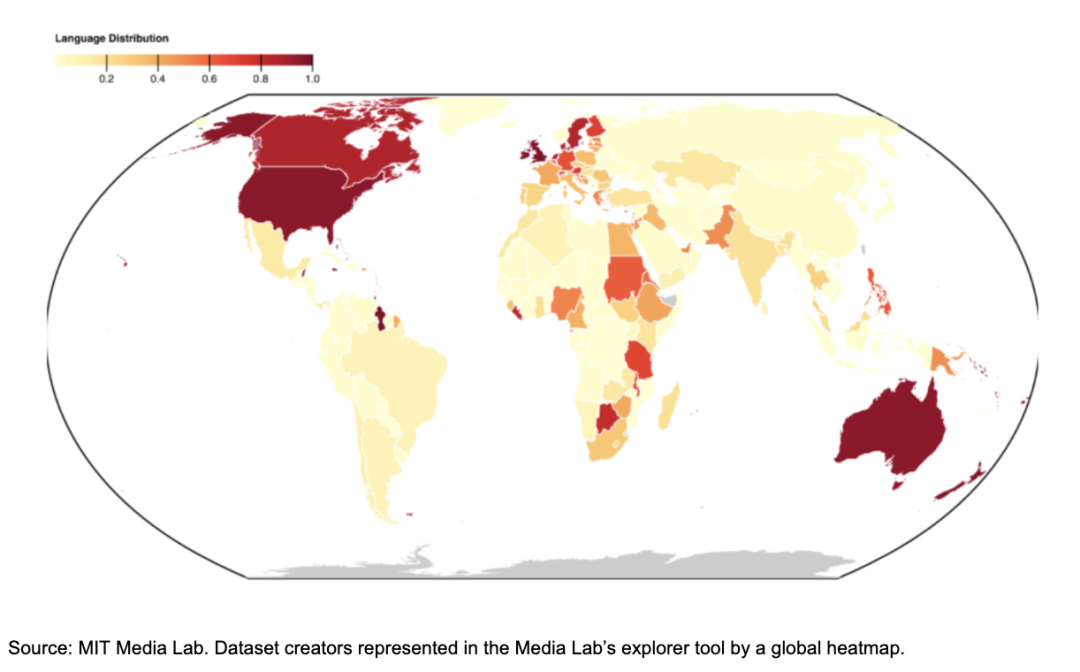

2024 年 3 月 1 日--"不要理会幕后黑手!"一个有力的声音响起,多萝西和她的同伴们难以置信地看着曾经令人生畏的幕后黑手轰然倒塌,露出了一个手握杠杆和诡计的笨拙巫师。与 "绿野仙踪 "中的有限幻象不同,当今的金融领域隐藏着一股强大得多的力量:人工智能(AI),利用算法能够协调经济发展与技术进步。 人工智能算法就像隐藏在翡翠城背后的齿轮,通过提高效率、预测趋势和个性化金融体验,正在改变金融业。从打击欺诈到简化交易,人工智能改善金融市场的潜力巨大。然而,与笨拙的巫师不同,人工智能拥有真正的力量,这就提出了一个关键的法律问题:我们能否真正信任我们看不见的东西? 这种不透明性通常被称为 "黑箱 "困境,对透明度至关重要的金融服务业提出了挑战。行业领导者已经注意到了这一点。摩根大通的杰米-戴蒙(Jamie Dimon)强调,人工智能系统必须是可解释的,这意味着它们不仅要做出决策,还要清楚地证明决策的合理性。例如,信用评分中可解释的人工智能可以透明地概述批准或拒绝贷款的原因。2023年12月,在参议院银行委员会一年一度的华尔街监管听证会上,戴蒙在国会作证时强调,摩根大通致力于明确、符合监管要求的客户信息披露,尤其是在信贷决策方面。 将人工智能融入金融行业带来了巨大的复杂性,其中法律和监管方面的挑战首当其冲。数据治理问题,如隐私、跨境数据流和遵守《通用数据保护条例》(GDPR)等法规至关重要。这些规则影响着人工智能在金融领域的发展和使用,决定着数据的处理方式,并确保系统尊重隐私和数据主权。 这种对清晰度的关注强调了人工智能数据治理的重要性,其中涉及各种许可框架。但是,要在人工智能的有效性与透明度之间取得平衡,仍然具有挑战性。牛津大学的迈克尔-奥斯本教授等学者主张开放性。同样,像全球人工智能数据集审计这样的倡议也是如此。 麻省理工学院媒体实验室推动合乎道德的数据使用。媒体实验室的热图--用颜色表示数值的数据图表--展示了全球范围内人工智能数据的生成情况,并通过语言规范化进行了公平比较。颜色越深的区域表示受政策和隐私法影响的数据集越多,反映了人工智能创新和包容性在法律和伦理方面的影响。这种分布强调了公平获取数据对塑造人工智能未来及其公平性的重要性。 人工智能融入金融领域的复杂性 这在法律上也有影响。在数据稀缺或受限于许可保护的地区,人工智能的发展有可能成为一个黑匣子--不透明,无法接受外部监督。这种不透明会加剧人工智能算法的保密性,使人们难以理解、质疑或改进其决策。这种情况凸显了人工智能发展中的一个关键节点:不负责任的人工智能系统可能会对整个社会产生深远影响。 人工智能算法的不透明性和数据的不平衡性带来了更多障碍,有可能掩盖决策,使偏见长期存在。例如,人工智能驱动的交易算法只需做出一个不明确的决定,就可能引发市场波动,这对监管机构保持问责制和实施预防战略提出了挑战。同样,信用评分系统也说明了由于缺乏透明度而导致监管困难的问题,有可能使历史数据中的偏见根深蒂固。 这些挑战因算法和人类偏见的相互作用而变得更加复杂,因此很难为有偏见的结果分配责任。人工智能有可能在无意中强化歧视性做法,如红线或针对弱势群体提供不合适的产品,这引起了人们的极大关注。 在金融领域,这些偏见可能会影响广泛的决策,这凸显了平衡人工智能的益处与偏见和歧视风险的迫切需要。 然而,监管机构正在争分夺秒地跟上步伐。2023 年 2 月,英国金融行为监管局(FCA)谴责了贷款公司因受有缺陷的算法影响,未进行充分的可负担性检查,将弱势客户置于风险之中,导致他们无法负担贷款。考虑到 Amigo 的财务困难和对高等法院授权的客户补偿计划的影响,FCA 放弃了 7290 万英镑的罚款。这种情况凸显了金融领域人工智能监管的复杂性,强调需要制定明确的法律框架来协调消费者保护与技术进步之间的关系。 在美国,《公平信用报告法》(FCRA)对消费者信用信息的使用规定了严格的准则。金融机构必须确保人工智能驱动的信用评分和贷款分配流程是透明、公平和非歧视性的。这一法律要求强调了对人工智能系统进行严格测试和监控以防止违规的重要性。联邦贸易委员会和消费者金融保护局等监管机构提供了指导意见和监督,以确保在数字时代遵守 FCRA 的规定。 人工智能融入金融领域的复杂性 传统的法律和监管框架以人类决策为基础,在面对人工智能的黑盒性质时面临挑战。由于人工智能决策背后的原理不透明或不容易理解,这种困境使得责任和义务的分配变得复杂,尤其是当这种决策导致不利结果或系统性风险时。 全球人工智能立法和指导方针越来越关注透明度、偏见、问责制和系统性风险等关键方面,以建立一个有弹性的金融生态系统,在利用人工智能优势的同时应对其潜在挑战。在这些努力中,走在前列的是欧盟的人工智能法,旨在规范人工智能系统的不透明性,尤其是在金融领域。 该法案预计将于 2024 年 4 月获得议会的最终批准,它为应对与高风险人工智能应用相关的风险、促进人工智能道德实践以及提高整个系统的透明度和问责制制定了全面的法律标准。 它为人工智能治理引入了一个金字塔框架,重点是基于风险的分类、严格的透明度要求和人工干预,以维护人工智能系统的问责制。这一立法结构旨在揭开人工智能决策过程的神秘面纱,确保人工智能的进步与社会价值观保持一致。 在全面的行政命令的指导下,美国正在通过行业驱动的倡议和自愿遵守的方式,引导实现负责任的人工智能。拜登政府于 2023 年 10 月发布的《全球报告》,主张在不执行严格规定的情况下提高透明度。 与此同时,英国在其 2023 年 7 月的白皮书中倡导在促进创新和管理风险之间保持微妙的平衡。报告强调了人工智能可解释性和减少偏见的重要性,主张采用支持创新的监管方法,同时强调国际合作的重要性。 这些共同努力突出表明,必须在监管进步与创新和道德考量之间取得平衡,确保人工智能在不同地区透明、负责地发展。 人工智能融入金融领域的复杂性 要实现协同增效的未来,就必须齐心协力,从不透明性的黑盒人工智能系统过渡到更加透明的玻璃盒模型,从而获得清晰的洞察力并增进信任。这一框架强调透明度而非保密性。简单地说,"玻璃盒子 "世界倡导开放和问责,而 "黑盒子 "世界则将决策过程隐藏在秘密之中。这一转变将由可解释人工智能(XAI)、区块链和量子计算的进步所推动,它们在重新定义金融服务和道德治理的轮廓方面都发挥着举足轻重的作用,最终将引领我们走向一个技术与透明并存的未来。 XAI 倡导人工智能系统阐明其推理过程,促进对人工智能决策的深入理解和信任。与此同时,区块链技术,尤其是其公共版本,有可能为金融交易带来前所未有的透明度。通过将交易记录保存在不可更改的分类账中,区块链可以加强信任并简化监管合规性。 量子计算有可能显著增强人工智能的分析能力,但也带来了有关数据隐私和安全的伦理问题。尽管存在这些问题,但量子计算无与伦比的处理能力有望彻底改变医疗保健、气候科学和金融等领域,为一些最复杂的社会问题提供解决方案。 问责制至关重要。在我们应对人工智能融入金融领域的复杂性时,过去的经验教训敦促我们建设一个创新与人类洞察力平衡的未来。通过拥抱新技术、采用全面的法律框架和促进国际合作,我们可以确保人工智能驱动的金融在创新方面开辟新天地,并为一个充满活力和繁荣的未来铺平道路。 原文标题: Legal transparency in AI finance: facing the accountability dilemma in digital decision-making By Joshua Dupuy 本文由ACFE China校对翻译,如需转载,请提前告知。 END